2024年4月份我写过一篇文章《用实例驳斥李彦宏开源模型会越来越落后》,当时使用的是开源的 LIama 3 测试,给出的结论是: 从 Meta AI 的表现来看,Llama 3在语言方面已经达到甚至超过了文心3.5的水平,更不用说Llama 3还支持多模态!只要有Meta这样的大公司在背后持续开源,那么开源模型必定能追上闭源模型!

2025年1月20号,DeepSeek正式发布了 DeepSeek-R1。22号我下载了 DeepSeek-R1 基于Qwen2.5 1.5B 7B 的蒸馏模型 DeepSeek-R1-Distill-Qwen-1.5B 和 DeepSeek-R1-Distill-Qwen-7B,测试了下,再一次感受到了开源的力量!这些模型参数量虽然比较小,但是通过“推理”,能解决之前开源的7B模型不能解决的问题。 更加坚信了我之前的观点,开源模型必定能追上闭源模型,甚至超越闭源模型!OpenAI 没有护城河!正如 Meta 的首席人工智能科学家杨立昆(Yann LeCun)所说,DeepSeek 的成功带来的最大启示是保持 AI 模型开源的重要性,这样每个人都能从中受益。 因为开源,领域专家可以居于他人的工作,提出新的想法,进行创新,然后回馈到开源社区,形成良性循环。从 Llama 3、Qwen 到 DeepSeek,我们真切领略到了开源领域所蕴含的强大创新力量!

互联网的自由与开放,是大数据得以不断积累的基石。在这个信息互通的时代,网络犹如全人类共享的巨型百科全书,持续为大模型输送知识养分。倘若这些珍贵的养分仅能被闭源模型所独享,无疑是一种极大的不公平。闭源模式限制了数据的流通与共享,让知识的传播与利用变得狭隘。

而开源模型则截然不同,它完美继承了互联网自由开放的精神。在开源的框架下,模型与算法能够在全球范围内自由流动,开发者们可以在此基础上进行协作与创新,模型的价值得到最大化发挥。这种开放的模式打破了技术壁垒,让更多人能够参与到人工智能的发展中来,推动整个行业不断进步。

安全绝非闭源的合理托辞。在开源体系中,安全同样是重中之重,会被审慎考量。开源的优势在于其高度透明,每一行代码都接受全球开发者的审视与检验,也更容易做安全测试,众人拾柴火焰高,这反而为安全增添了多道坚实防线,比闭源更具保障。

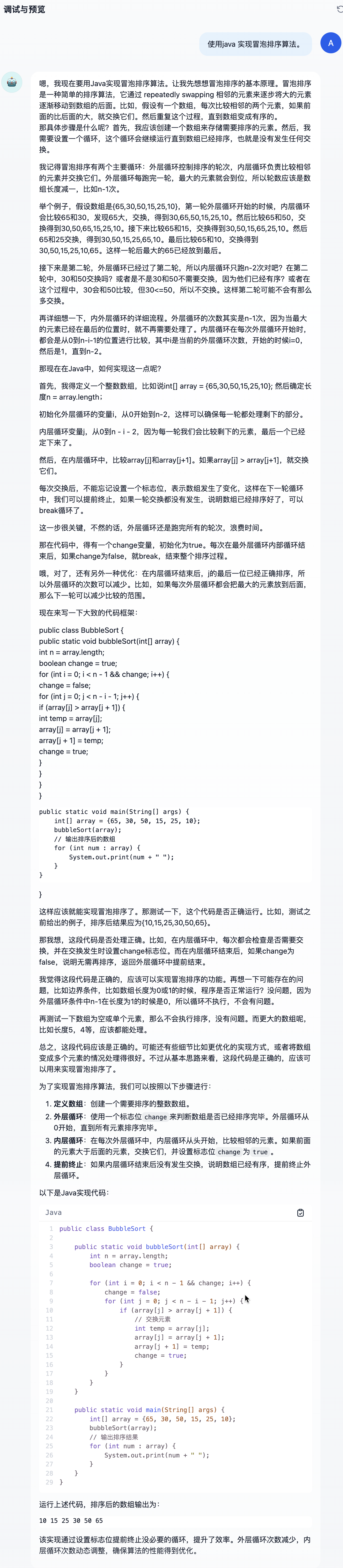

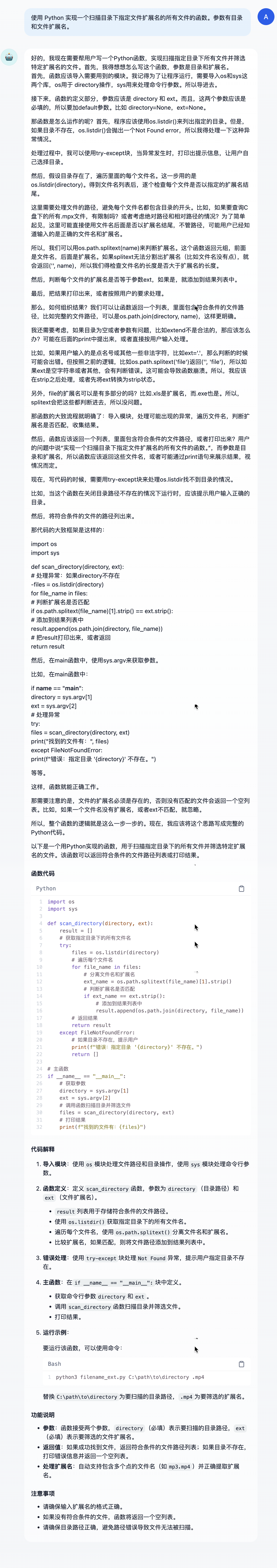

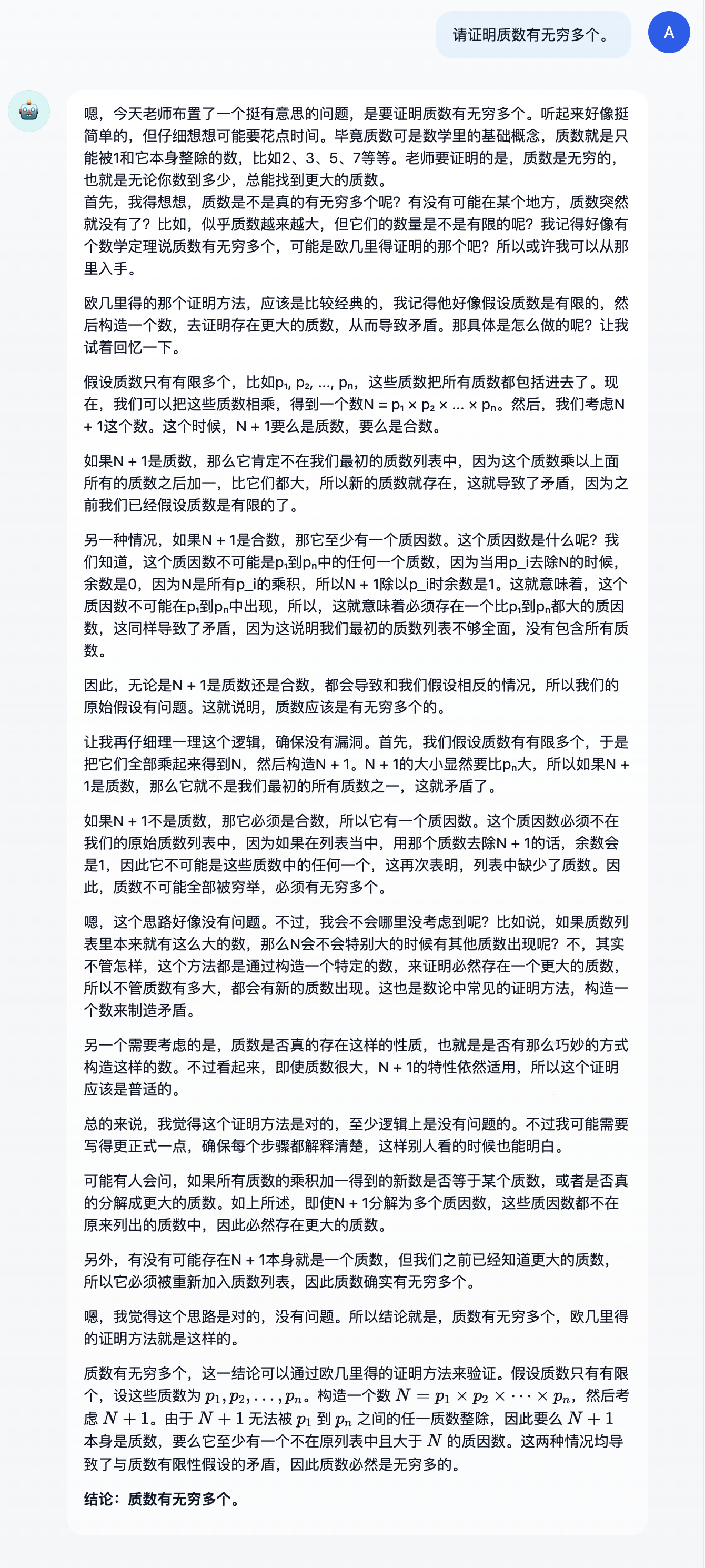

DeepSeek-R1-Distill-Qwen-7B 模型测试如下:

前面是思考过程,可以看到非常有逻辑性,最后的代码也是正确的。特别的,它还通过设置标志位,提前终止没必要的循环,提升了效率。

代码正确。

思考过程和最后的证明都是正确的。

再用 DeepSeek-R1-Distill-Qwen-1.5B 测试了下,第1问和第3问也都回答正确,第2问代码有些问题。

最后说下我的观察:

通过大模型蒸馏出小模型加上推理能力,小的模型也有非常强大的泛化能力。 目前模型所谓的推理能力,我觉得是通过增加模型回忆相关问题上下文的能力,这样就能更好地发挥已有的知识储备,减少幻觉。

目前大模型可以很好地解决用语言描述的问题,已经有了依葫芦画瓢的能力。但是我用小学三年级的数学周长问题(需要视觉分析)喂给图像理解模型,发现模型并不能真正理解,视觉的问题大模型还有待新的创新和突破。